PyTorch Lightning là gì? Tại sao nên sử dụng PyTorch Lightning?

- Hướng dẫn tất cả về Công cụ PyTorch giải toán AI

- Triển khai Autoencoder và mạng GAN bằng PyTorch Lightning

Trong thế giới học máy và học sâu (deep learning), PyTorch đã trở thành một trong những thư viện phổ biến nhất nhờ vào tính linh hoạt, dễ sử dụng và khả năng tùy chỉnh cao. Tuy nhiên, khi các dự án học sâu trở nên phức tạp hơn, việc quản lý mã nguồn và tổ chức quy trình huấn luyện mô hình có thể trở thành một thách thức lớn. Đây chính là lúc PyTorch Lightning xuất hiện như một công cụ mạnh mẽ để giải quyết vấn đề này. Trong bài viết này, chúng ta sẽ tìm hiểu PyTorch Lightning là gì, cách nó hoạt động và lý do tại sao nên sử dụng nó trong các dự án học sâu.

1. PyTorch Lightning là gì?

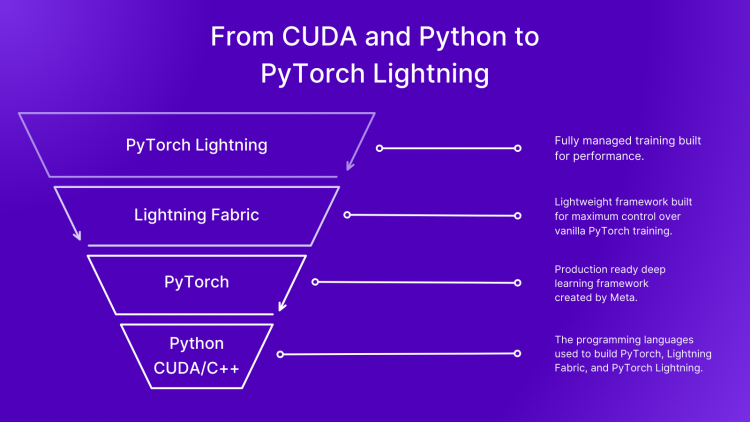

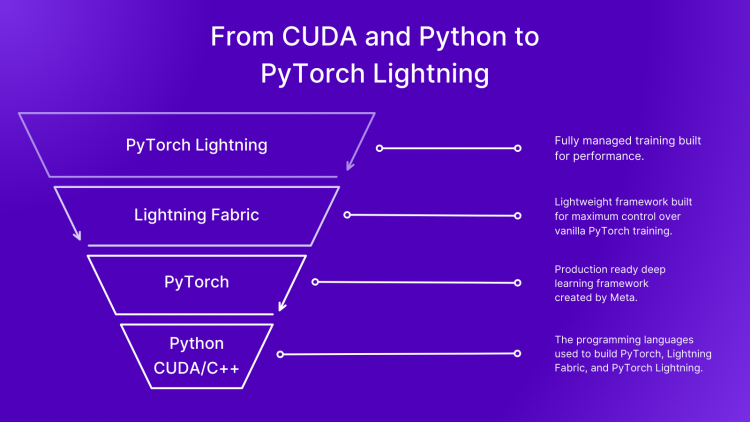

PyTorch Lightning là một thư viện mã nguồn mở được xây dựng trên nền tảng PyTorch, nhằm đơn giản hóa quy trình phát triển các mô hình học sâu mà vẫn giữ được tính linh hoạt của PyTorch. Nó được thiết kế để loại bỏ các đoạn mã lặp đi lặp lại (boilerplate code), giúp mã nguồn trở nên rõ ràng, dễ đọc và dễ bảo trì hơn. PyTorch Lightning không phải là một thư viện thay thế PyTorch, mà là một “lớp vỏ” (wrapper) cung cấp cấu trúc và các tính năng nâng cao để tổ chức mã nguồn một cách hiệu quả.

PyTorch Lightning được phát triển bởi nhóm Lightning AI và cộng đồng mã nguồn mở. Nó ra đời với mục tiêu giúp các nhà nghiên cứu và kỹ sư học máy tập trung vào việc thiết kế mô hình và thử nghiệm ý tưởng, thay vì mất thời gian vào các chi tiết kỹ thuật như vòng lặp huấn luyện (training loop), quản lý thiết bị (GPU/CPU), hoặc các tác vụ như lưu trữ checkpoint và ghi log.

>>>Xem thêm:Vertex AI là gì? Tính năng, lợi ích của công cụ trong Doanh nghiệp

2. Các thành phần cốt lõi của PyTorch Lightning

PyTorch Lightning tổ chức mã nguồn theo một cách có cấu trúc và mô-đun. Một số thành phần chính của nó bao gồm:

- LightningModule: Đây là trung tâm của PyTorch Lightning, thay thế cho lớp nn.Module trong PyTorch truyền thống. LightningModule không chỉ chứa kiến trúc mô hình mà còn tích hợp các phương thức như forward, training_step, validation_step, test_step và cấu hình tối ưu hóa (configure_optimizers).

- Trainer: Đây là đối tượng chịu trách nhiệm quản lý toàn bộ quy trình huấn luyện, bao gồm vòng lặp huấn luyện, kiểm định (validation), kiểm tra (test), và các tính năng như tự động lưu checkpoint, sử dụng nhiều GPU, hoặc tích hợp với các công cụ ghi log như TensorBoard, Weights & Biases.

- DataModule: PyTorch Lightning cung cấp LightningDataModule để quản lý dữ liệu một cách thống nhất. Nó giúp tách biệt logic xử lý dữ liệu (như tải dữ liệu, chia tập huấn luyện/kiểm định) khỏi logic huấn luyện mô hình.

- Callbacks: Đây là các hàm tùy chỉnh có thể được gọi tại các thời điểm cụ thể trong quá trình huấn luyện, chẳng hạn như lưu mô hình tốt nhất, điều chỉnh tỷ lệ học (learning rate), hoặc dừng sớm (early stopping) khi hiệu suất không cải thiện.

Nhờ các thành phần này, PyTorch Lightning cung cấp một cách tiếp cận có tổ chức hơn so với việc viết mã PyTorch thuần túy, giúp giảm thiểu lỗi và tăng khả năng tái sử dụng mã.

3. Tại sao nên sử dụng PyTorch Lightning?

PyTorch Lightning mang lại nhiều lợi ích vượt trội cho cả người mới bắt đầu và các chuyên gia trong lĩnh vực học sâu. Dưới đây là những lý do chính khiến bạn nên cân nhắc sử dụng PyTorch Lightning trong dự án của mình.

>>>Xem thêm:DeepAI là gì? Các tính năng nổi bật và hướng dẫn sử dụng chi tiết nhất

1. Giảm thiểu mã lặp đi lặp lại

Khi sử dụng PyTorch thuần túy, bạn thường phải viết rất nhiều đoạn mã lặp đi lặp lại cho các tác vụ như vòng lặp huấn luyện, kiểm định, và quản lý thiết bị. Ví dụ, một vòng lặp huấn luyện cơ bản trong PyTorch có thể trông như sau:

python

CollapseWrapCopy

for epoch in range(num_epochs):

model.train()

for batch in train_loader:

x, y = batch

x, y = x.to(device), y.to(device)

optimizer.zero_grad()

output = model(x)

loss = loss_fn(output, y)

loss.backward()

optimizer.step()

Với PyTorch Lightning, tất cả logic này được gói gọn trong LightningModule. Bạn chỉ cần định nghĩa các phương thức như training_step và để Trainer tự động xử lý phần còn lại:

python

CollapseWrapCopy

class MyModel(pl.LightningModule):

def __init__(self):

super().__init__()

self.model = nn.Linear(10, 1)

self.loss_fn = nn.MSELoss()

def forward(self, x):

return self.model(x)

def training_step(self, batch, batch_idx):

x, y = batch

y_hat = self(x)

loss = self.loss_fn(y_hat, y)

return loss

def configure_optimizers(self):

return torch.optim.Adam(self.parameters(), lr=0.001)

model = MyModel()

trainer = pl.Trainer(max_epochs=10)

trainer.fit(model, train_dataloader)

Như bạn thấy, mã trở nên ngắn gọn và dễ đọc hơn rất nhiều. PyTorch Lightning tự động xử lý các chi tiết như chuyển dữ liệu sang GPU, gọi zero_grad(), backward(), và step().

2. Tăng tính tái sử dụng và khả năng bảo trì

Một trong những vấn đề lớn khi làm việc với PyTorch thuần túy là mã nguồn có thể trở nên rối loạn khi dự án mở rộng. Với PyTorch Lightning, cấu trúc mã được tổ chức rõ ràng, giúp tăng khả năng tái sử dụng và bảo trì. Ví dụ, bạn có thể dễ dàng chuyển đổi giữa các mô hình hoặc bộ dữ liệu mà không cần viết lại toàn bộ vòng lặp huấn luyện.

Ngoài ra, PyTorch Lightning khuyến khích tách biệt logic mô hình (LightningModule) và logic dữ liệu (DataModule), giúp mã nguồn trở nên mô-đun và dễ kiểm thử.

3. Hỗ trợ huấn luyện phân tán và đa GPU

Huấn luyện mô hình học sâu trên nhiều GPU hoặc nhiều node là một nhiệm vụ phức tạp nếu sử dụng PyTorch thuần túy. PyTorch Lightning tích hợp sẵn hỗ trợ cho huấn luyện phân tán (distributed training) và đa GPU. Bạn chỉ cần chỉ định tham số gpus trong Trainer:

python

CollapseWrapCopy

trainer = pl.Trainer(gpus=4) # Sử dụng 4 GPU

PyTorch Lightning sẽ tự động xử lý các chi tiết như đồng bộ hóa gradient giữa các GPU, đảm bảo hiệu suất tối ưu mà không cần bạn phải viết mã bổ sung.

4. Tích hợp dễ dàng với các công cụ ghi log và tối ưu hóa

PyTorch Lightning tích hợp sẵn với các công cụ ghi log như TensorBoard, Weights & Biases, và Comet.ml. Bạn có thể dễ dàng ghi lại các số liệu như loss, accuracy, hoặc các tham số khác trong quá trình huấn luyện:

python

CollapseWrapCopy

self.log(‘train_loss’, loss, on_step=True, on_epoch=True)

Ngoài ra, PyTorch Lightning cung cấp các tính năng tối ưu hóa như tự động điều chỉnh tỷ lệ học (learning rate scheduling), lưu checkpoint mô hình tốt nhất, hoặc dừng sớm khi hiệu suất không cải thiện.

5. Dễ dàng mở rộng và tùy chỉnh

Mặc dù PyTorch Lightning cung cấp một cấu trúc mặc định, nó vẫn rất linh hoạt và dễ dàng tùy chỉnh. Bạn có thể ghi đè bất kỳ phương thức nào trong LightningModule hoặc Trainer để đáp ứng nhu cầu cụ thể của dự án. Điều này đảm bảo rằng PyTorch Lightning không làm mất đi tính linh hoạt của PyTorch mà vẫn cung cấp một khung làm việc có tổ chức.

Ví dụ, nếu bạn muốn thêm logic tùy chỉnh trong quá trình huấn luyện, bạn chỉ cần ghi đè phương thức training_step hoặc sử dụng callbacks.

6. Cộng đồng và tài liệu phong phú

PyTorch Lightning có một cộng đồng người dùng lớn và tài liệu chính thức rất chi tiết. Tài liệu của PyTorch Lightning cung cấp nhiều ví dụ thực tế, từ các mô hình đơn giản như MLP đến các mô hình phức tạp như Transformer hoặc GAN. Điều này giúp người dùng mới dễ dàng bắt đầu và người dùng nâng cao tìm thấy các giải pháp cho các vấn đề phức tạp.

7. Tăng tốc độ phát triển và thử nghiệm

Với PyTorch Lightning, bạn có thể nhanh chóng thử nghiệm các ý tưởng mới mà không phải lo lắng về việc viết lại các đoạn mã lặp đi lặp lại. Điều này đặc biệt hữu ích trong nghiên cứu, khi bạn cần thử nhiều kiến trúc mô hình, bộ siêu tham số (hyperparameters), hoặc bộ dữ liệu khác nhau.

4. Khi nào không nên sử dụng PyTorch Lightning?

Mặc dù PyTorch Lightning mang lại nhiều lợi ích, nó không phải lúc nào cũng là lựa chọn tốt nhất. Nếu dự án của bạn rất đơn giản hoặc bạn cần kiểm soát hoàn toàn từng chi tiết của vòng lặp huấn luyện, việc sử dụng PyTorch thuần túy có thể phù hợp hơn. Ngoài ra, nếu bạn đang làm việc với một hệ thống có yêu cầu rất đặc biệt mà PyTorch Lightning không hỗ trợ trực tiếp, bạn có thể gặp khó khăn khi phải tùy chỉnh quá nhiều.

5. Kết luận

PyTorch Lightning là một công cụ mạnh mẽ giúp đơn giản hóa và tổ chức quy trình phát triển mô hình học sâu mà vẫn giữ được tính linh hoạt của PyTorch. Với khả năng giảm thiểu mã lặp đi lặp lại, hỗ trợ huấn luyện phân tán, tích hợp với các công cụ ghi log, và tăng tính tái sử dụng, PyTorch Lightning là lựa chọn lý tưởng cho cả người mới bắt đầu và các chuyên gia trong lĩnh vực học sâu.

Nếu bạn đang làm việc với các dự án học sâu phức tạp hoặc muốn tăng tốc độ phát triển và thử nghiệm, PyTorch Lightning chắc chắn đáng để thử. Bằng cách sử dụng nó, bạn có thể tập trung vào việc thiết kế mô hình và thử nghiệm ý tưởng, thay vì mất thời gian vào các chi tiết kỹ thuật. Hãy thử PyTorch Lightning trong dự án tiếp theo của bạn và trải nghiệm sự khác biệt!

>>>Xem thêm:DeepL Translator: Công cụ dịch thuật hàng đầu nhanh chóng và chính xác

Nguyễn Cúc

Bình luận (0

)