BigML và Explainable AI: Diễn giải quyết định của các mô hình máy học

BigML và Explainable AI (XAI) giúp người dùng hiểu quy trình ra quyết định của các mô hình máy học, thúc đẩy niềm tin và sự tự tin vào công nghệ.

- Orange3 - Công cụ lập trình trực quan kéo thả dễ dàng

- AI Kubeflow Pipelines - Nền tảng công nghệ ứng dụng trí tuệ nhân tạo độc đáo

- Khám phá sự khác biệt giữa AutoKeras và AutoML

- Hướng dẫn đầy đủ về cách sử dụng LightGBM dành cho người mới

- Grok AI là gì? Hướng dẫn Cách sử dụng Grok 3 AI chatbot mới nhất

BigML và Explainable AI (XAI) giúp người dùng hiểu quy trình ra quyết định của các mô hình máy học, thúc đẩy niềm tin và sự tự tin vào công nghệ.

Nền tảng BigML và nhu cầu diễn giải các mô hình machine learning

Trong những năm gần đây, trí tuệ nhân tạo (AI) và máy học (ML) đã đạt được những tiến bộ đáng kể, biến đổi nhiều ngành công nghiệp và tự động hóa nhiều nhiệm vụ. Tuy nhiên, khi các công nghệ này trở nên phức tạp hơn, thì ngày càng có nhiều mối lo ngại về khả năng diễn giải và giải thích được các quyết định do các mô hình này đưa ra. Điều này đã dẫn đến sự xuất hiện của Explainable AI (XAI), một lĩnh vực nhằm mục đích làm cho các mô hình AI và ML trở nên minh bạch và dễ hiểu hơn đối với con người. Một công ty đi đầu trong phong trào này là BigML, nhà cung cấp dịch vụ máy học hàng đầu tập trung vào việc làm cho ML có thể truy cập và hiểu được cho mọi người.

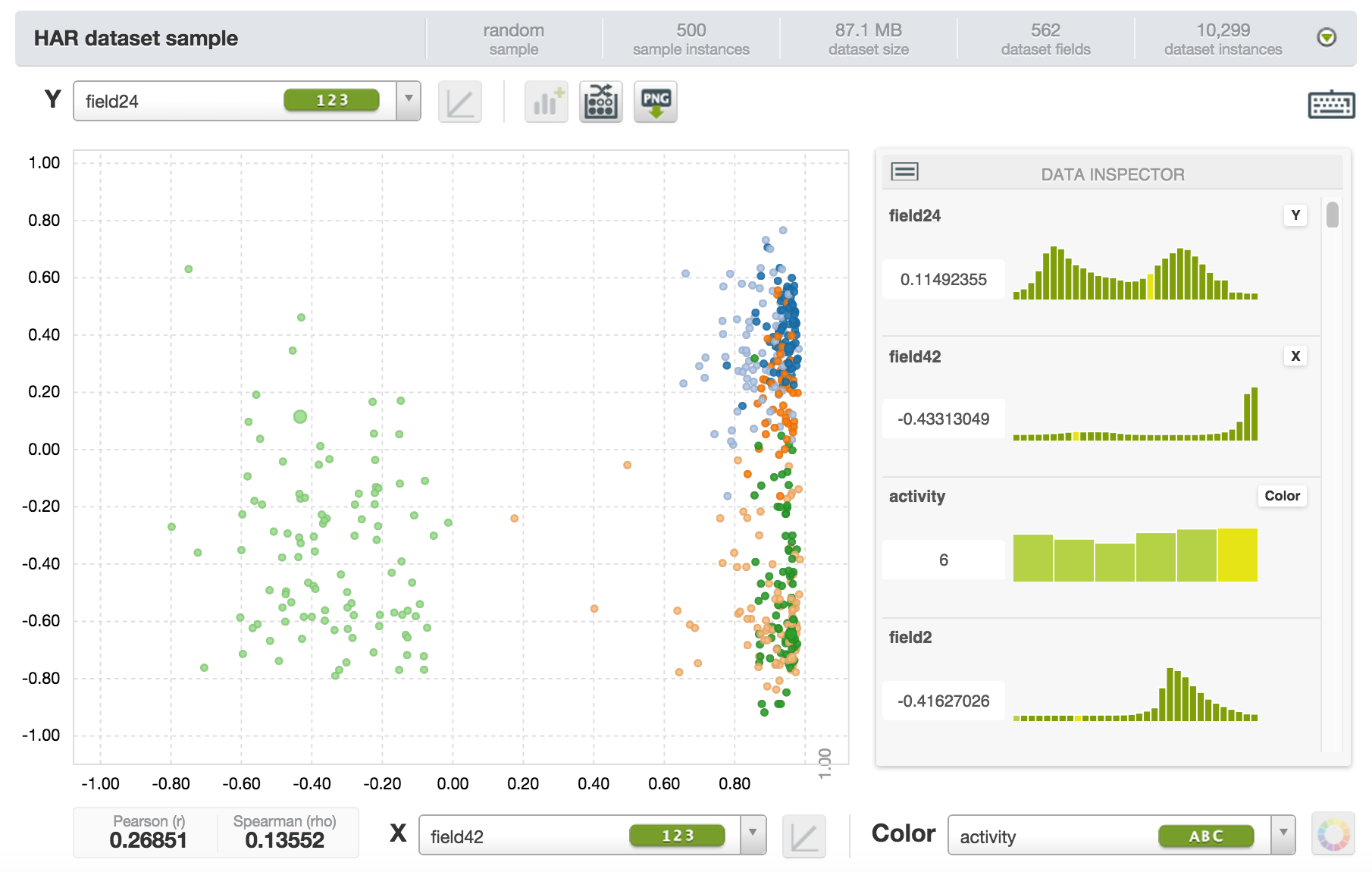

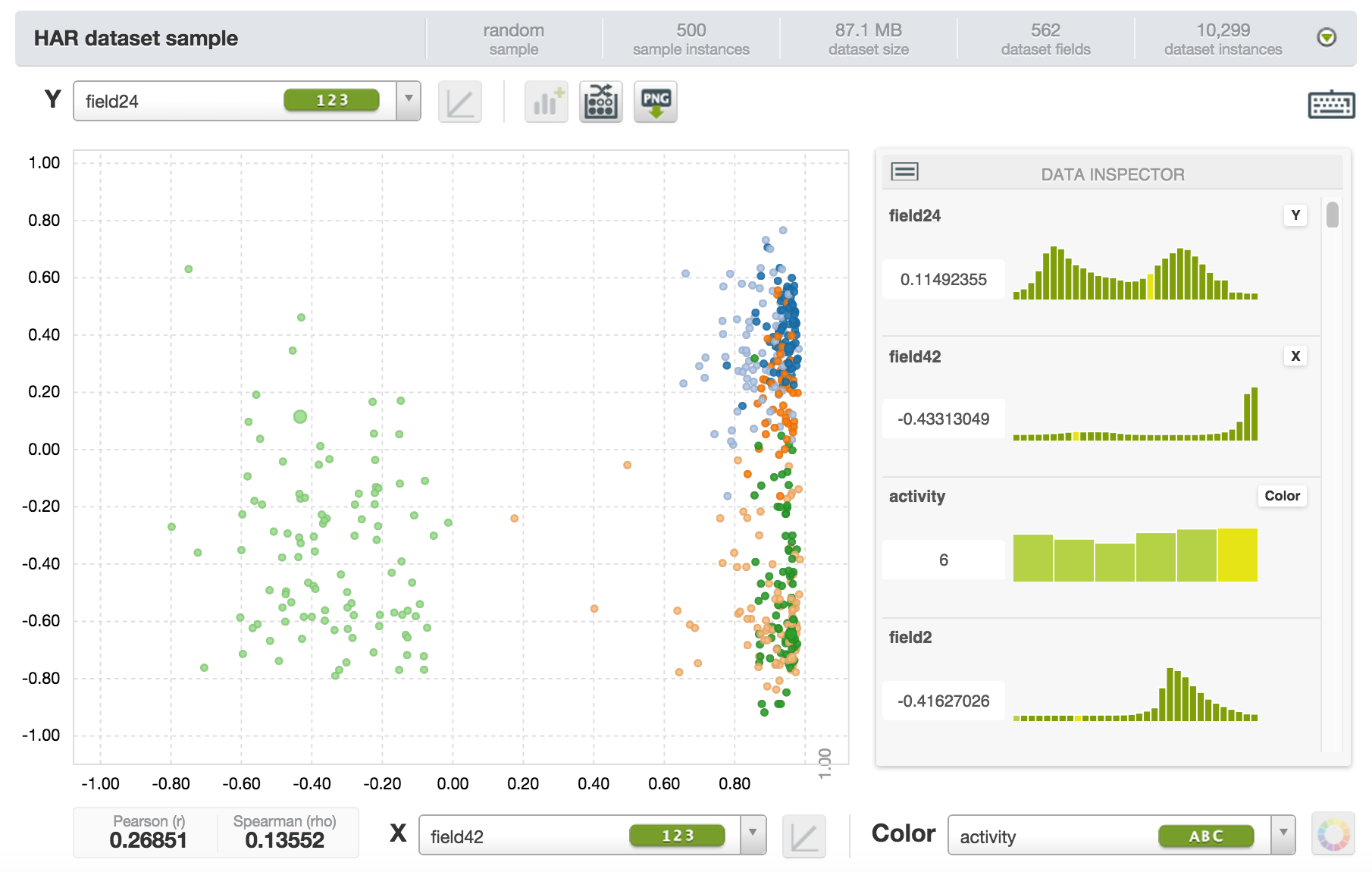

Nền tảng của BigML cung cấp một loạt các thuật toán và công cụ ML cho phép người dùng tạo, phân tích và triển khai các mô hình một cách dễ dàng. Một trong những tính năng chính của nền tảng BigML là nhấn mạnh vào khả năng giải thích và khả năng diễn giải. Bằng cách cung cấp cho người dùng hình ảnh trực quan và giải thích về các mô hình của họ, BigML giúp người dùng hiểu quy trình ra quyết định của các mô hình ML của họ, thúc đẩy niềm tin và sự tự tin vào công nghệ.

Các kỹ thuật của BigML

Cây quyết định (decision trees)

Một trong những cách BigML đạt được điều này là thông qua việc sử dụng cây quyết định, một kỹ thuật ML phổ biến vốn có thể hiểu được. Cây quyết định là biểu diễn đồ họa của quá trình ra quyết định, trong đó mỗi nút biểu thị một quyết định dựa trên một tính năng cụ thể và mỗi nhánh biểu thị kết quả của quyết định đó. Bằng cách trực quan hóa quá trình ra quyết định theo cách này, người dùng có thể dễ dàng hiểu cách mô hình đưa ra dự đoán và có thể xác định bất kỳ sai lệch hoặc vấn đề tiềm ẩn nào trong mô hình.

Sơ đồ phụ thuộc một phần (PDP)

Một kỹ thuật khác được BigML sử dụng để tăng cường khả năng giải thích là sơ đồ phụ thuộc một phần (PDP). PDP giúp người dùng hiểu mối quan hệ giữa một tính năng cụ thể và các dự đoán của mô hình bằng cách chỉ ra cách các dự đoán thay đổi khi giá trị của tính năng thay đổi. Điều này cho phép người dùng hiểu rõ hơn về tầm quan trọng của từng tính năng trong mô hình và cách nó ảnh hưởng đến các quyết định của mô hình.

LIME

BigML cũng cung cấp LIME, một kỹ thuật giải thích các dự đoán riêng lẻ bằng cách xấp xỉ mô hình bằng một mô hình đơn giản hơn, có thể hiểu được, chẳng hạn như hồi quy tuyến tính hoặc cây quyết định. LIME cung cấp thông tin chi tiết về quy trình ra quyết định của mô hình cho một trường hợp cụ thể, cho phép người dùng hiểu lý do tại sao mô hình đưa ra dự đoán cụ thể và xác định bất kỳ vấn đề hoặc thành kiến tiềm ẩn nào.

Bộ công cụ đánh giá và xác thực mô hình

Ngoài các kỹ thuật này, nền tảng của BigML còn bao gồm một bộ công cụ để đánh giá và xác thực mô hình, chẳng hạn như ma trận nhầm lẫn, đường cong đặc tính vận hành máy thu (ROC) và đường cong thu hồi độ chính xác. Những công cụ này giúp người dùng đánh giá hiệu suất của các mô hình của họ và xác định bất kỳ vấn đề hoặc lĩnh vực tiềm ẩn nào cần cải thiện.

Khi AI và ML tiếp tục đóng vai trò ngày càng quan trọng trong cuộc sống của chúng ta, nhu cầu về các mô hình có thể giải thích và diễn giải trở nên cấp thiết hơn. Bằng cách cung cấp cho người dùng một bộ công cụ và kỹ thuật toàn diện để hiểu và diễn giải các mô hình của họ, BigML đang giúp thu hẹp khoảng cách giữa thế giới phức tạp của ML và người dùng hàng ngày.

Kết luận

Tóm lại, việc BigML nhấn mạnh vào Explainable AI là một bước quan trọng để thúc đẩy niềm tin và sự tin tưởng vào các công nghệ AI và ML. Bằng cách làm cho quy trình ra quyết định của các mô hình ML minh bạch và dễ hiểu hơn, BigML đang trao quyền cho người dùng đưa ra quyết định sáng suốt về việc triển khai và sử dụng các công nghệ này. Khi lĩnh vực AI tiếp tục phát triển, điều cần thiết đối với các công ty như BigML là ưu tiên khả năng giải thích và khả năng diễn giải, đảm bảo rằng mọi người đều có thể tiếp cận và hiểu được lợi ích của AI và ML.

Quỳnh Anh (dịch từ Ts2.space: https://ts2.space/en/bigml-and-explainable-ai-interpreting-the-decisions-of-machine-learning-models/)

Tin liên quan:

- Sai lầm khiến bạn dễ nản khi học lập trình và cách vượt qua

- FUNiX mở rộng hợp tác tại Nhật, thêm cơ hội việc làm cho học viên

- Xây dựng văn hóa học tập: Biến suy thoái thành cơ hội

- Chuyện nữ sinh học trực tuyến để tốt nghiệp đại học sớm

- 5 cách tìm việc IT khôn ngoan cho người ít kinh nghiệm

- Nhân sự nghỉ việc từ công ty lớn khó khăn thích nghi với startup

- Những lưu ý quan trọng dành cho bạn khi chuyển ngành học

- Tại sao CNTT là lĩnh vực nghề nghiệp hấp dẫn hiện nay

- Các yếu tố quan trọng quyết định thành công trong sự nghiệp IT

Bình luận (0

)