Google cảnh báo nhân viên về chatbot

Thông tin này đã được xác nhận, trích dẫn trong chính sách dài hạn về bảo vệ thông tin của Google liên quan đến chatbot.

- Khóa học phát triển kỹ năng AI cho sinh viên: chìa khóa mở cánh cửa tương lai số

- Học AI giúp sinh viên dễ xin việc tăng lợi thế cạnh tranh trong thị trường lao động mới

- Học AI cơ bản cho học sinh - Khởi đầu sớm, lợi thế lớn

- Dạy AI cho học sinh trường chuyên THPT – Học hiểu nhanh, ôn thi hiệu quả

- Chương trình AI cho sinh viên đại học - Gợi ý từ FUNiX để bắt đầu đúng hướng

Ngày 15/6 vừa qua, công ty mẹ của Google đã khuyên nhân viên không nhập các tài liệu bí mật của mình vào các chatbot AI, kể cả phần mềm Bard của chính Google.

Sự thận trọng của Google

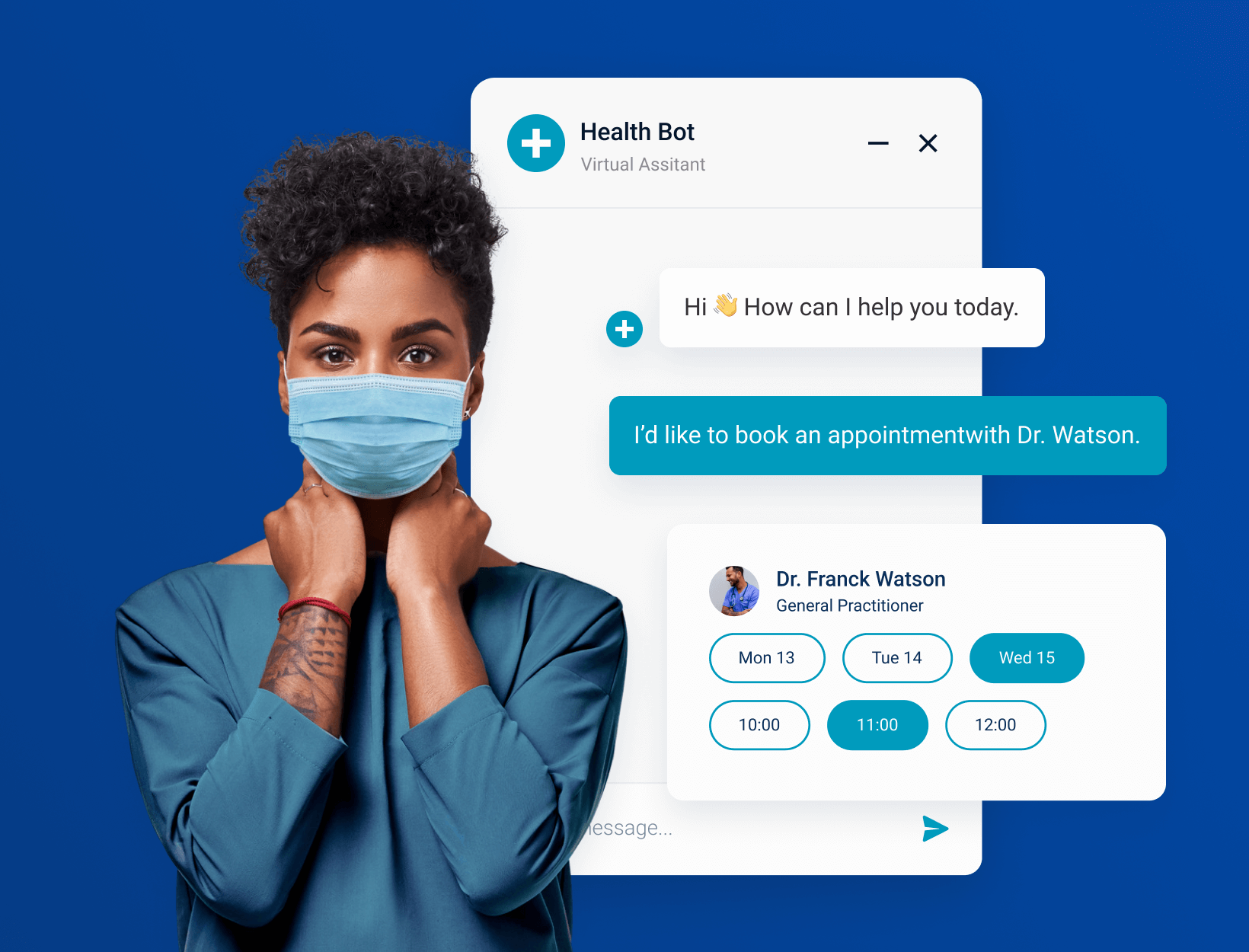

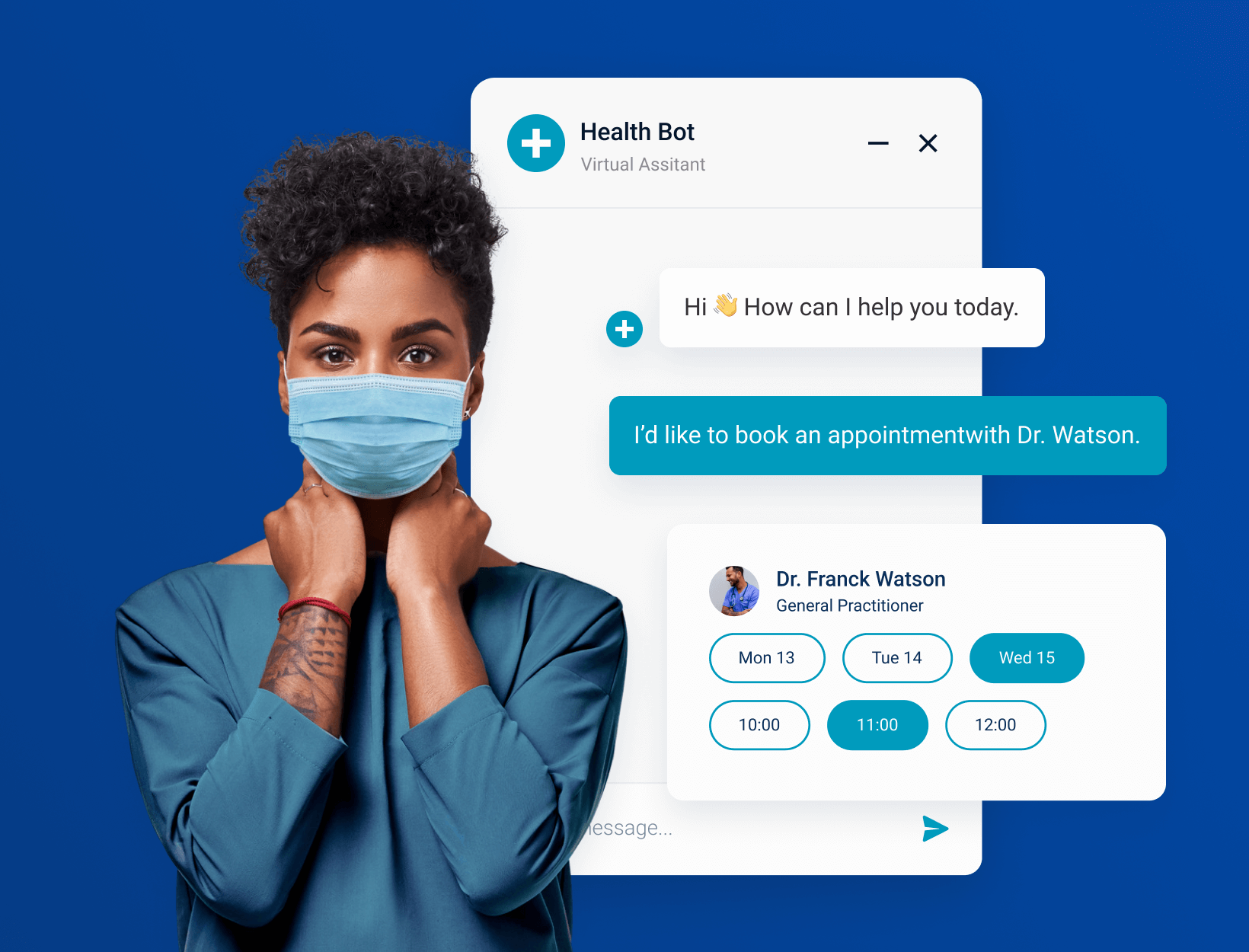

Các chatbot, trong số đó có Bard và ChatGPT, là các chương trình sử dụng trí tuệ nhân tạo tổng quát để tổ chức các cuộc trò chuyện với người dùng. Trong quá trình nghiên cứu, các kỹ sư phát hiện ra rằng AI có thể tái tạo dữ liệu mà nó hấp thụ trong quá trình đào tạo, tạo ra nguy cơ rò rỉ thông tin.

Một số nhân viên của Alphabet cũng cho biết công ty đã cảnh báo các kỹ sư của mình tránh sử dụng trực tiếp mã máy tính mà chatbot tạo ra.

Google cho biết Bard có thể đưa ra các đề xuất mã không mong muốn, nhưng dù sao thì nó cũng giúp ích cho các lập trình viên. Công ty cũng thông tin họ muốn minh bạch về những hạn chế trong công nghệ của mình.

Nhiều yếu tố cho thấy Google đang muốn tránh các tổn thất kinh doanh từ phần mềm mà hãng tung ra trongchiến dịch cạnh tranh với ChatGPT. Khoản đầu tư hàng tỷ đô la đang bị đe dọa trong cuộc đua của Google với những người ủng hộ ChatGPT là OpenAI và Microsoft Corp (MSFT.O), chưa kể đến doanh thu quảng cáo và đám mây từ các chương trình AI mới.

Sự thận trọng của Google cũng phản ánh những gì đang trở thành tiêu chuẩn bảo mật cho các tập đoàn, cụ thể là cảnh báo nhân viên về việc sử dụng các chương trình trò chuyện công khai.

Đồng bộ việc bảo mật thông tin

Ngày càng nhiều doanh nghiệp trên khắp thế giới đã thiết lập các biện pháp bảo vệ trên các chatbot AI, trong số đó có Samsung (005930.KS), Amazon.com (AMZN.O) và Deutsche Bank (DBKGn.DE),. Apple (AAPL.O) cũng được cho là có động thái tương tự.

Google cho biết họ đã có các cuộc trò chuyện chi tiết với Ủy ban bảo vệ dữ liệu của Ireland và đang giải quyết các câu hỏi của cơ quan quản lý, sau một báo cáo của Politico vào ngày 13/6 cho rằng công ty đã hoãn việc ra mắt phiên bản Bard thị trường châu Âu trong tuần này để chờ thêm thông tin về tác động của chatbot đối với quyền riêng tư.

Lo lắng về thông tin nhạy cảm

Các công nghệ AI có thể soạn thảo email, tài liệu, thậm chí cả phần mềm, hứa hẹn sẽ tăng tốc đáng kể các tác vụ. Tuy nhiên, nội dung này có thể chứa thông tin sai lệch, dữ liệu nhạy cảm hoặc nhiều vấn đề về bản quyền.

Thông báo về quyền riêng tư của Google được cập nhật vào ngày 1/6 cũng nêu rõ: “Không cung cấp các thông tin bí mật hoặc nhạy cảm của bạn trong các cuộc trò chuyện trên Bard.”

Một số công ty đã phát triển phần mềm để giải quyết những lo ngại như vậy. Chẳng hạn, Cloudflare (NET.N) đang tiếp thị khả năng cho các doanh nghiệp gắn thẻ cũng như cung cấp các dịch vụ đám mây khác và hạn chế các dữ liệu rò rỉ, bảo vệ các trang web khỏi các cuộc tấn công mạng.

Cập nhật điều chỉnh chatbot

Google và Microsoft cũng đang cung cấp các công cụ đàm thoại cho khách hàng doanh nghiệp với mức giá cao hơn nhưng không thu thập dữ liệu vào các mô hình AI công cộng. Cài đặt mặc định trong Bard và ChatGPT là lưu lịch sử hội thoại của người dùng, người dùng có thể chọn xóa lịch sử này.

Yusuf Mehdi, Giám đốc tiếp thị người tiêu dùng của Microsoft cho biết việc các công ty không muốn nhân viên của họ sử dụng chatbot công cộng cho công việc là hợp lý.

Mehdi cho biết: “Các công ty đang có quan điểm thận trọng hợp lý khi giải thích cách so sánh chatbot Bing miễn phí của Microsoft với phần mềm doanh nghiệp của họ. “Ở đó, các chính sách của chúng tôi nghiêm ngặt hơn nhiều.”

Microsoft từ chối bình luận về việc liệu họ có lệnh cấm hoàn toàn đối với nhân viên nhập thông tin bí mật vào các chương trình AI công khai hay không, bao gồm cả chương trình của chính họ, mặc dù một giám đốc điều hành khác cho biết rằng cá nhân ông đã hạn chế sử dụng.

Matthew Prince, Giám đốc điều hành của Cloudflare, nói rằng việc nhập các vấn đề bí mật vào chatbot giống như “lật tẩy một loạt nghiên cứu sinh tiến sĩ trong tất cả các hồ sơ cá nhân của bạn.”

Quỳnh Anh (dịch từ Reuters)

Link bài gốc: https://www.reuters.com/technology/google-one-ais-biggest-backers-warns-own-staff-about-chatbots-2023-06-15/

Tin liên quan:

- 3 lý do nên học lập trình trước tuổi 18

- Những hoạt động giúp trẻ em học cách đặt mục tiêu

- Trẻ em thỏa sức sáng tạo với ngôn ngữ lập trình Scratch

- Trẻ em học FUNiX: Cơ hội và hướng dẫn để chinh phục IT

- Độ tuổi nên cho trẻ em học lập trình và cách để trẻ học CNTT hiệu quả

Bình luận (0

)